使用iServer内置Spark前的环境准备 |

将 SuperMap iServer 产品包拷贝至集群成员所在的机器中之后,您就可以在各平台上进行使用前的环境配置了。如果您使用的是 Windows 平台(仅支持64位操作系统)的 iServer 产品包,只需开放端口并配置三方依赖。

使用 iServer 分布式分析服务的推荐硬件配置包括:

为保证分布式集群正常工作,Windows 和 Linux 系统都需要修改防火墙配置,开放以下端口:

自行下载 kafka-clients-0.10.0.1.jar 、spark-streaming-kafka-0-10_2.11-2.3.2.jar 两个三方依赖包,下载完成后将两个依赖包复制至 '【iServer 安装目录】/support/spark/jars' 下:

如果您使用的Linux平台产品包,除了开放必要的端口以外,为保证各集群节点间能够准确识别并通信,还需要修改Linux平台的主机名。这里以三台 Ubuntu 虚拟机为例,其 IP 分别为

Master:192.168.177.136

Worker1: 192.168.177.135

Worker2:192.168.177.137

以下操作需要以 root 用户执行。通过如下命令可由普通用户切换至root用户:

sudo -i

再次输入当前用户密码即可。

打开 hostname 的配置文件:

vi /etc/hostname

将主机名修改为sparkmaster,Worker节点中的主机名则改为sparkworker1、sparkworker2。

保存并退出文件编辑后,通过以下命令查看本机IP地址:

ifconfig

设置主机名与IP的对应关系,打开/etc/hosts文件:

vi /etc/hosts

添加如下配置:

192.168.177.136 sparkmaster

192.168.177.135 sparkworker1

192.168.177.137 sparkworker2

三个节点的 hosts 文件配置相同。保存并退出编辑。重启虚拟机。

通过以下命令可查看当前主机名是否修改成功:

hostname

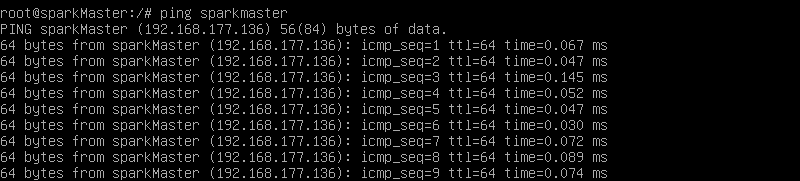

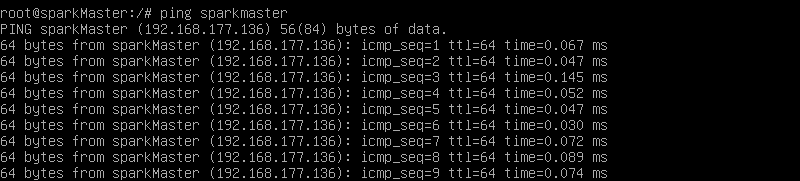

使用 ping 命令查看主机名与IP对应关系是否正确:

ping [hostname]

例如:

ping sparkmaster

请先确认war 包部署前的环境配置是否正确,war包部署成功后,您还需要在各平台上依次进行以下操作来配置分布式分析服务的环境:

1. 解压对应平台的 support 压缩文件,可看到其目录下有 hadoop 和 spark 文件夹。

2. 在 iserver 文件夹(中间件部署 iserver.war 时生成的)所在目录的上一级新建 support 文件夹,将步骤1解压目录中的 hadoop 和 spark 文件夹放置其中。

1. 在环境变量中添加 HADOOP_HOME,可设置为 iServer 内置的 hadoop 的目录,并将%HADOOP_HOME%\bin 加入到系统的 PATH 环境变量中。(Linux平台无需设置 hadoop 环境变量)

2. 在环境变量中添加 SPARK_HOME,可设置为 iServer 内置的 Spark 的目录,并将%SPARK_HOME%\bin 加入到系统的 PATH 环境变量中。

3. 在环境变量中添加 SPARK_SCALA_VERSION,值为 2.11.8。